大数据(Big Data)是今年刚刚流行起来的一个名词,其主要基于新的且具有突破性的技术。根据调研统计,未来五年,预计大数据内容将会占据数据总量的50%以上。大数据提供了巨大的尚未开发的价值,作为企业寻求应变信息爆炸的途径,其必然会遭遇到来自互联网基础设施的压力与变化。

Internet Research Group发布的调查数据显示了企业广域网对大数据的影响。

大数据常被定义为数据集,其大小超出了传统数据库软件工具捕捉,存储,管理和分析的能力。大数据的大小基本都在PB级别,而且是非结构化数据,在单一层面模式下实行分发。由于大数据的持续增长,业内人士预计这一市场将发生巨大变化,同时企业将会意识到尚未开发的的价值。报告显示,大多数公司将在明年或者12至18个月内采用大数据的关键技术。

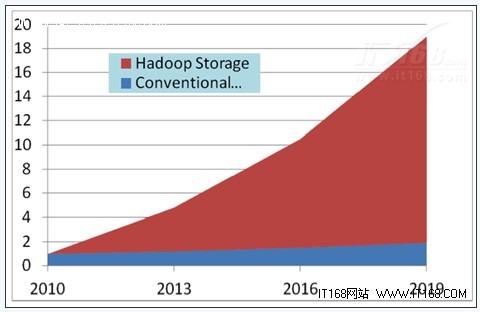

Internet Research Group发布的调查数据显示了未来数年中,Hadoop存储与常规存储方式的数据量对比

富有挑战性的网络容量

所有数据都需要捕捉、存储、处理和分发,而这一过程很有可能会堵塞网络。在Hadoop的管理之下,每PB的大数据都需要0.5 Gbps的带宽以进行传输。

在Internet Research Group的报告中,涵盖了如下主要趋势:

更便宜的存储定价。传统数据存储的费用是每GB 5美元,而在同样容量下,Hadoop的成本是0.25美元。

增强的可扩展性。 Hadoop使企业能够用很少的成本为此前购买的存储添加额外的存储空间。 Hadoop的可扩展性,将会使得未来五年内50%以上的数据都存储在Hadoop环境中。

对未捕捉数据的分析。在大数据以外的领域,只有1%至5%的数据部署为用户所分析。因此,大数据的存在价值正在于那些没有经过分析的市场。麦肯锡最近报道了一个医疗保健行业的案例,这一机构近期分析了95%的未捕获的数据,预计这些数据每年的价值约为300亿美元。缺乏数据分析的一个反例是石油工业,某石油公司只使用其所产生信息的5%。

该报告认为,用户正在部署Hadoop集群来作为一个集中服务,使独立站点不用建立和运行自己的设备,“越大越好”,这是未来处理批处理工作负载的一个方向。

因此,基于以上内容,我们可以得出结论,Big Data必将引发Big Traffic(大流量),特别是在数据中心和数据中心之间。数据迁移,包括但不限于复制和同步,将成为特别重要的内容。这正是由于Hadoop在企业存储中的风靡所引发的潮流。大流量的数据迁移服务能够支持大数据分析,合规性要求,高可用性服务和安全服务。

我们一直都在努力坚持原创.......请不要一声不吭,就悄悄拿走。

我原创,你原创,我们的内容世界才会更加精彩!

【所有原创内容版权均属TechTarget,欢迎大家转发分享。但未经授权,严禁任何媒体(平面媒体、网络媒体、自媒体等)以及微信公众号复制、转载、摘编或以其他方式进行使用。】

微信公众号

TechTarget

官方微博

TechTarget中国

翻译

相关推荐

-

Micron开始向部分客户发售更密集的QLC SSD

Micron Technology公司开始向部分客户发售采用新型高密度QLC 3D NAND闪存技术的企业固态 […]

-

阿里巴巴发布面向下一代数据中心的双模SSD存储架构

阿里巴巴今日发布了面向下一代数据中心的双模SSD(Dual-Mode SSD)存储架构,以及全球首个双模SSD […]

-

大数据隐私保护措施有哪些?

每年频发的数据泄露事件总会带来一些教训,其中一条就是,无论何时开始采取数据保护措施永远不会太晚。幸运的是,企业表现出更加关注数据隐私方面的工作。

-

大数据给数据中心带来哪些改变?

大数据时代的来临首先对数据中心行业产生巨大影响。企业需要的是可扩展的存储解决方案,并且与业务一起发展,另外,安全问题已提上日程。