在上一篇的《技术者》中,给大家推荐了SAS Switch的部署攻略,今天继续来看基于SAS Switch的服务优化肿麽破。

共享启动盘的服务

在基于SAS Switch的硬件构架之上易于实现一系列的优化服务。比如共享启动盘的管理。在机群上的每个服务器都需要一个装有该机器应该运行的操作系统的盘卷,此外通常还需要提供虚存对换空间以及根文件系统。前者作为操作系统的软件映像通常是只读的,且在大型数据中心中,不同机器之间采用重复的操作系统的映像的可能性很高。后者通常需要可写,并且机器之间共享的可能性不大,但后者通常所需的空间较小。要为成百上千的服务器结点管理这些盘卷,既需要硬件成本,又是个运维的负担。提供低成本,便利,有可靠的启动盘卷服务,是一个有价值的挑战。

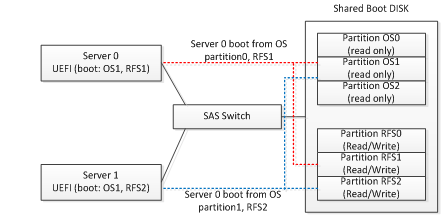

有了SAS Switch我们可以试图在物理盘的层次支持共享启动盘卷的。 采用把一个(或采用一对共享盘来提供热备份)高性能的盘(例如SAS SSD) 在物理上创建多个分区。可有两类分区,第一类存放共享的操作系统的静态映像,不同分区对应于机群上可能要使用的不同的操作系统版本,第二类分区,是用于存放单台机器的根文件系统,因此需要为每台单独服务器创建一个根文件系统分区。把这个共享启动盘连接到SAS Switch的拓扑上,然后可通过SAS Switch 把该盘共享给所有需要通过它来启动的服务器结点。在服务器侧,需要安装一个UEFI BIOS应用,用以负责接受SAS Switch的管理配置(包括使用SAS Switch所指定的盘,特定分区上找到操作系统映像,并用另一个所指定的分区上找到根文件系统)来进行物理服务器的启动操作。

在上图所展示的例子中,两台服务器(server 0, server 1)通过SAS Switch共享了一个启动盘。 其中服务器0 采用了OS分区1上的操作系统,并把自己的根文件系统放在私有的RFS1分区上,而服务器1同样采用了OS分区1上的操作系统,而把根文件系统放在了私有的RFS2分区上,因此两太服务器在运行时不会互相干扰。

这样的简单方法,会导致系统的可靠性下降。如果共享的启动盘发生硬件故障,会导致整个机群的不能启动。可以通过在系统中配置两个或多个共享启动盘来提高系统可靠性。比如通过SAS Switch为每台服务器结点配置3个共享启动盘以及在启动盘上的相应分区。在服务器的UEFI 启动应用上,当发现第一个启动盘正常工作时,切换到使用第二或第三个启动盘。并且还需要把3个共享启动盘安装在不同的故障域内(例如:位于不同的JBOD当中,甚至在不同的机架中)。这样,单个共享启动盘的故障不会导致整个机群的故障。

采用共享的启动盘,除了可以消除每台服务器内安装两个启动盘的成本,还带来其他运维上的便利性。操作系统和应用的升级可以通过在共享的启动盘上更新操作系统映像分区的数据来完成,而不需要对每台服务器结点的映像进行逐一更新。而当服务器结点硬件发生故障时,只需更新服务器,而不需重新安装操作系统和软件。这些可在大规模数据中心中节约大量的运维成本。

动态业务的弹性迁移和保护

在一个SAS Switch构成的域内由于所有服务器结点都能访问到所有存储资源,这为动态业务的弹性迁移和保护提供了基础。

以一个Hadoop大数据分析的业务机群为例。 在该例子中,初始配置了10台服务器和20个数据盘。每个服务器上分配了2个HDFS数据盘。通过机群管理系统对系统的运行状态进行性能评测和监控,这包括了动态测量每台服务器的CPU使用效率,IOPS, 带宽等,并且对每个盘的IOPS和带宽也进行检测。动态检测的结果发现Hadoop结点上CPU的使用效率只有18%。 管理调度层 (通过人工干预或自动调度的策略)决定对该Hadoop 机群进行资源的重新配置,并决定把计算服务器结点减少到2个,并把原有的20个HDFS数据盘重新分配到剩余的2个服务器上,每个服务器接管10个HDFS 数据盘。新的资源配置通过管理接口配置到SAS Switch上。这个重新配置可在Hadoop业务在线的情况下完成。被释放的8个空闲的CPU可重新分配给机群上的其他业务使用。即使在没有其他业务可利用这8个CPU的情况下,也可以把把它们设置到睡眠等节省电能的状态。而剩余的2个CPU在重新配置完成后继续执行原有的Hadoop计算业务。重新配置后剩余的CPU可基本达到接近100%的利用效率。

对需要高可靠性的业务,也可通过SAS Switch实现业务保障。例如采用1:1或N:1的保护倒换的方法,在一个服务器结点发生故障时,把该结点承担的业务调度到机群内一个空闲的服务器结点,并且把原有分配给发生故障的服务器的存储资源重新分配给替换的服务器结点,这样的动态替换可在业务在线的情况下完成,从而保证业务的持续性。

超融合存储

目前存储业界对超融合存储(例如: Nutanix, VMWare VSan)或称 Server SAN的技术有很多关注。这类技术正在经历高速增长的发展。对传统的SAN和存储系统造成了严重的冲击。

该技术有3个突出的特点:1)采用标准服务器而不采用专门的硬件系统来实现存储业务层的功能。2)完全采用软件技术来实现机群内的所有服务器直接连接的存储(DAS)资源的池化。3)采用机群内的服务器结点既运行存储业务,也运行用户的应用。即用户的业务应用程序和超融合的存储业务共生在同一服务器结点上。

表面看来,该技术应该可消除专门用于连接存储资源的存储交换网络(如SAN等Storage Fabric),还可消除传统的专用存储系统硬件。而完全采用通用服务器的硬件系统。但是,生产服务器的厂商却有不同的看法:超融合存储软件极大地催生了对SAS Switch 这类简单的后端存储Fabric技术,以及存储资源解耦合的硬件构架在刀片和机架服务器上的应用,即采用高密度刀片或机架服务器+SAS Switch+JBOD的硬件构架来实现超融合系统。归纳下来有如下原因:

1)通过把盘从刀片或机架服务器内部挪到更便宜的JBOD上,优化了“地价”成本,从而使得服务器计算结点密度提高,成本降低。这个优化的思路在本文的第一部分已有论述。

2)由于用户应用程序和存储业务共生在同一个CPU上,而用户应用对硬件资源的需求最优配比千差万别,难以向所有用户推荐统一的集成了CPU和存储资源的砖块服务器型号。而要根据用户的具体应用来进行优化,这就需要把存储和计算解耦合。

3)在公有云,VDI等许多应用场景,需要支持在同一个机群硬件设施上支持多个房客(Multi-Tenant),而出于数据安全的考虑,许多客户要求服务提供方保证他们的私有数据和其他访客的数据在物理上隔离(即存放在物理隔离的盘上,物理上保障其他用户的虚拟机不可能访问到他们的私有数据)。这样的物理隔离在SAS Switch上很方便就可实现。

综上所述,我们十分欣慰地看到,SAS Switch 在大型数据中心以及企业存储领域的许多应用场景已经开始进入大规模部署的阶段。我们过去几年所提倡的解耦合,存储资源池化的设想也随之变成现实。在中国数据中心的天蝎2.0的机架上,我们看到了基于SAS Switch的产品日趋成熟。这催生了中国数据中心在这个技术路线上的超越美国率先进入了存储池化的时代,让云技术更先进,更有弹性,更经济,更环保。而在国际市场上,我们也看到了主流服务器厂商以及各类数据中心的积极跟进。2015年 SAS Switch 正当时。

我们一直都在努力坚持原创.......请不要一声不吭,就悄悄拿走。

我原创,你原创,我们的内容世界才会更加精彩!

【所有原创内容版权均属TechTarget,欢迎大家转发分享。但未经授权,严禁任何媒体(平面媒体、网络媒体、自媒体等)以及微信公众号复制、转载、摘编或以其他方式进行使用。】

微信公众号

TechTarget

官方微博

TechTarget中国

相关推荐

-

切换云供应商如芒刺在背 如何应对?

云存储带来诸多便利,例如提高灵活性、按需付费以及近乎无限的扩展,但还有一件事没有解决。即便在理想状况下,你或许仍然需要花上近一天的时间来切换云存储服务商,这或将成为一种不堪重负的过程。

-

私有化转型 :RackSpace被收购

Rackspace与Amazon的AWS,Microsoft的Azure一样,是最早一批云服务供应商。而这家公司也进入私有化转型,将被股权公司收购。

-

Pokémon Go带给存储的一点启示

Pokémon Go最近极为火爆,是因为它的增强现实能力以及服务器宕机事件——这对于存储管理员来说也有值得学习的地方。

-

专访陈清金:从联通沃云的超融合存储说开去

据悉,联通新一代云数据中心已部署超融合架构,并平稳运行。截至目前,在国内共有云领域,联通沃云已成为超融合部署规模最大,数据容量达PB级。